使用Ollama與Open WebUI在本地端部署Llama3大語言模型

文/恆逸資深講師 申建忠

Ollama是一個使用Go語言開發的本地端大語言模型框架,可以在本地端執行多種開放原始碼的大語言模型,如:Llama 3、Mistral、Gemma等。其中Meta Llama 3以15T語料進行訓練,模型效果號稱無限接近ChatGPT4。

本文介紹如何在本地端安裝Ollama與Open WebUI,並使用Ollama運行Meta Llama 3:8b模型。

首先至Ollama官網(https://ollama.com)下載對應版本的ollama執行檔,下載完成後直接點擊安裝即可。本文以Apple Macbook pro 2018為例。

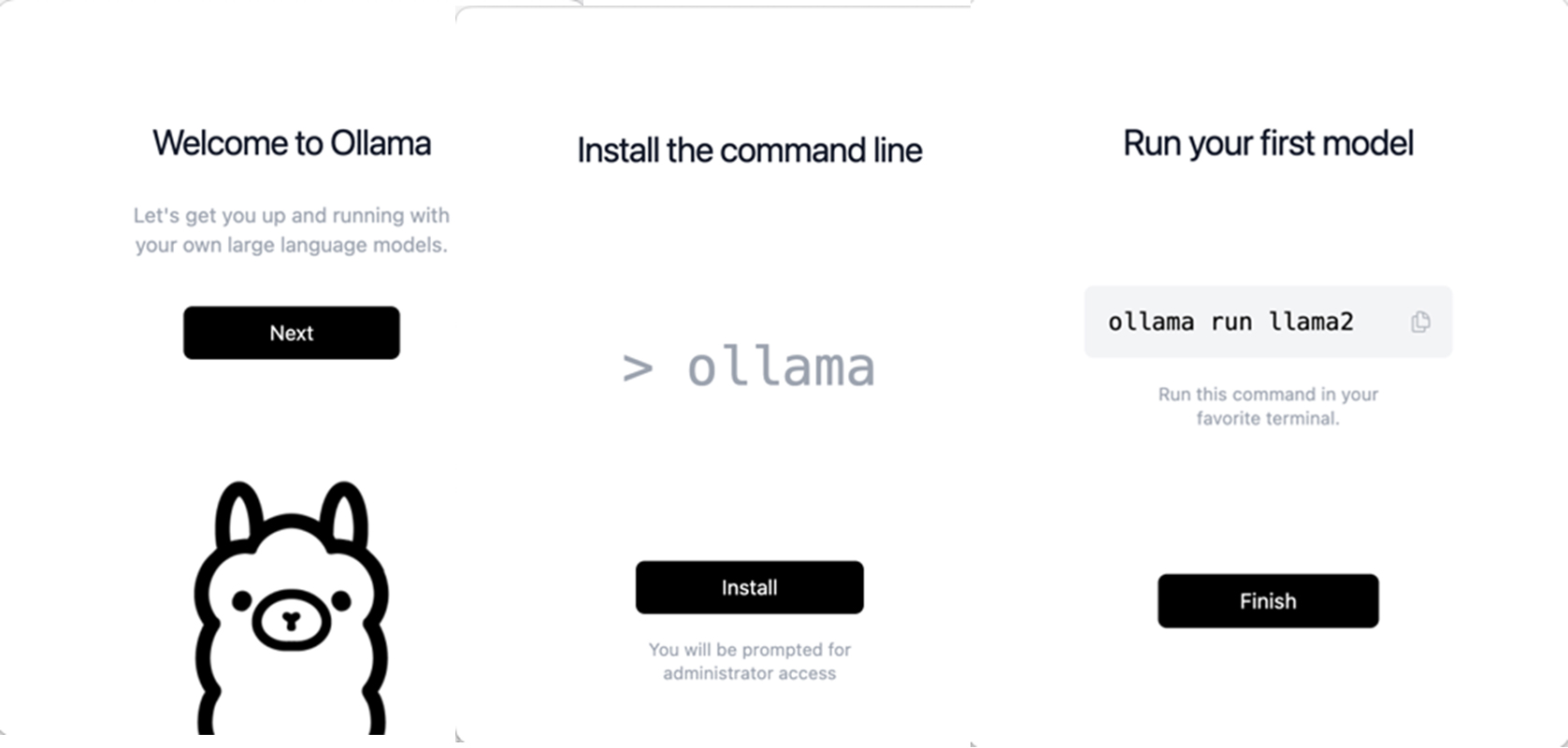

安裝完成後,請點擊ollama執行檔啟動ollama設定。

依下面圖示,由左向右便可設定完成。

可以使用curl http://localhost:11434 測試ollama是否啟動,若出現此訊息”Ollama is running”表示ollama已經啟動。

設定完成後,直接使用終端機執行”ollama run 模型名字”即可。

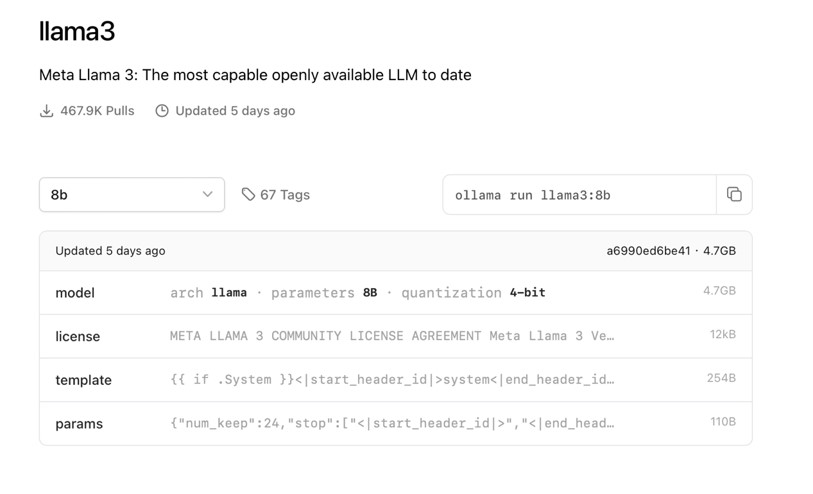

Ollama目前支援的模型可由https://ollama.com/library 查看。本文將部署目前最強大的模型:Meta Llama 3,Llama 3有兩種版本:80億(8B)與700億(70B),由於示範機器本身限制,所以選擇部署llama3:8b。

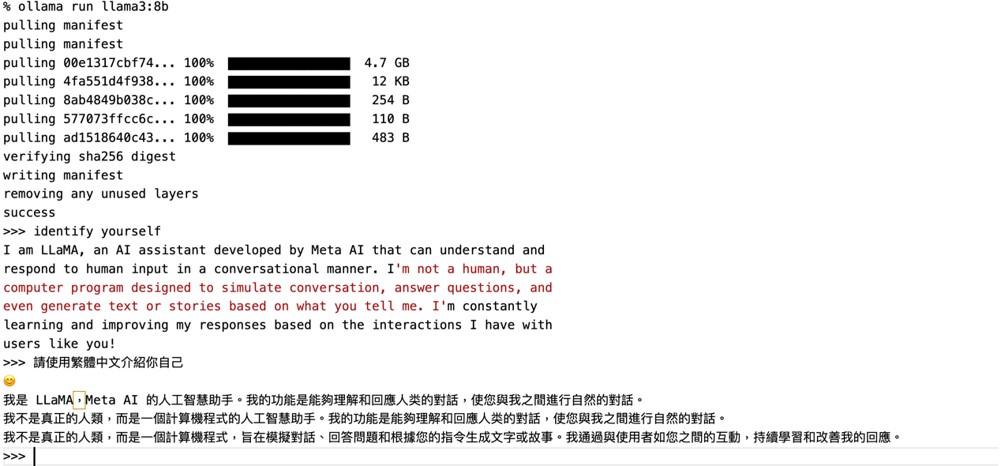

請注意初次執行llama3:8b模型,須從ollama.com下載模型約4.7GB,需要花費一些時間,但後續執行便不再需要下載。

$ ollama run llama3:8b

結束此次對話,直接輸入/bye即可離開。之後再次執行ollama run llama3:8b便可重新開始與llama3:8b的對話。

但是不是每個人都能夠接受終端機介面,此處介紹另一個docker container:Open WebUI(之前的名字是Ollama WebUI),使用容器提供Web-Based介面。

首先必須在本機端安裝Docker運行環境,請依據本機端的作業系統平台,從https://www.docker.com下載並安裝對應的Docker運行環境。

安裝Docker完成後,可以使用docker -v測試,若出現類似訊息”Docker version 26.0.0, build 2ae903e”表示Docker已經安裝成功。

執行” docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main”

初次執行時,需要花費一些時間下載open-webui映像檔,但往後便不再需要再次下載映像檔。

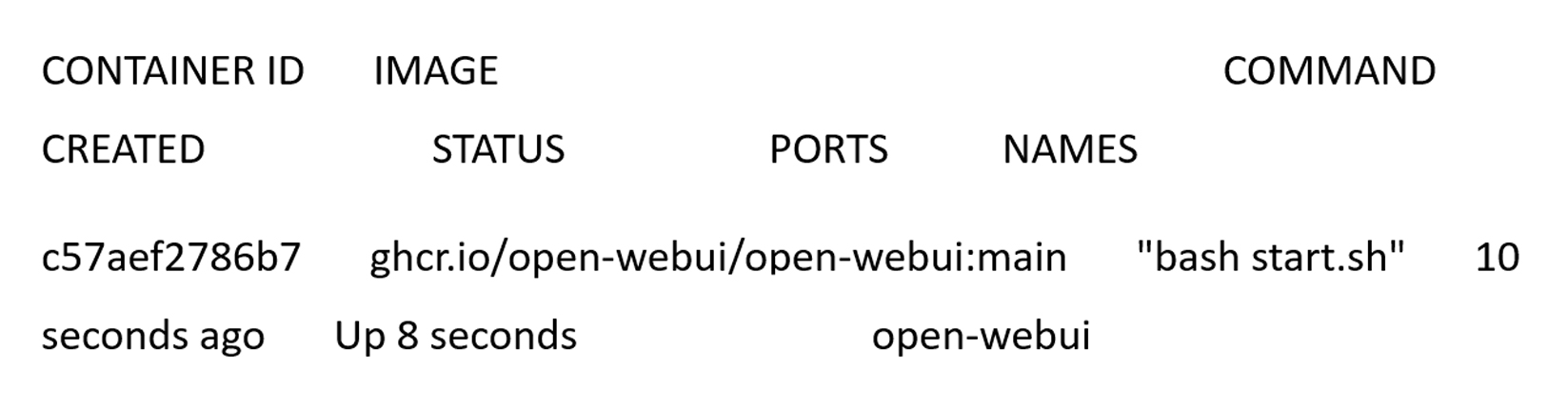

執行docker ps檢視open-webui容器是否執行中

若出現類似上面訊息,接著可以使用瀏覽器開啟 http://localhost:3000 進入Open WebUI。

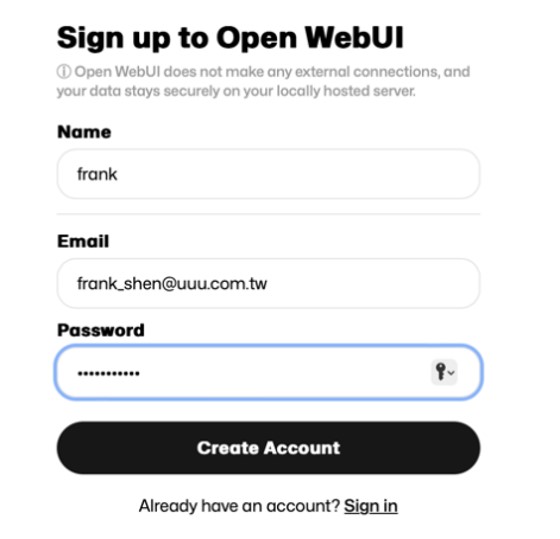

初次登入Open WebUI需要註冊一個帳戶,畫面如下

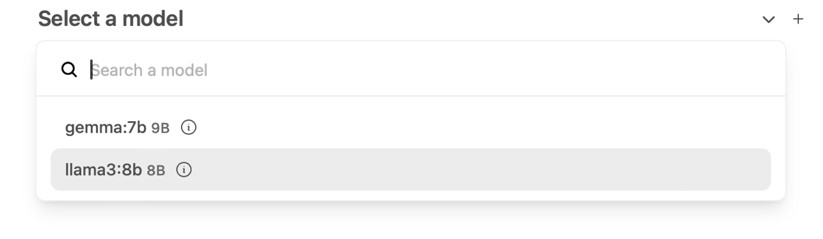

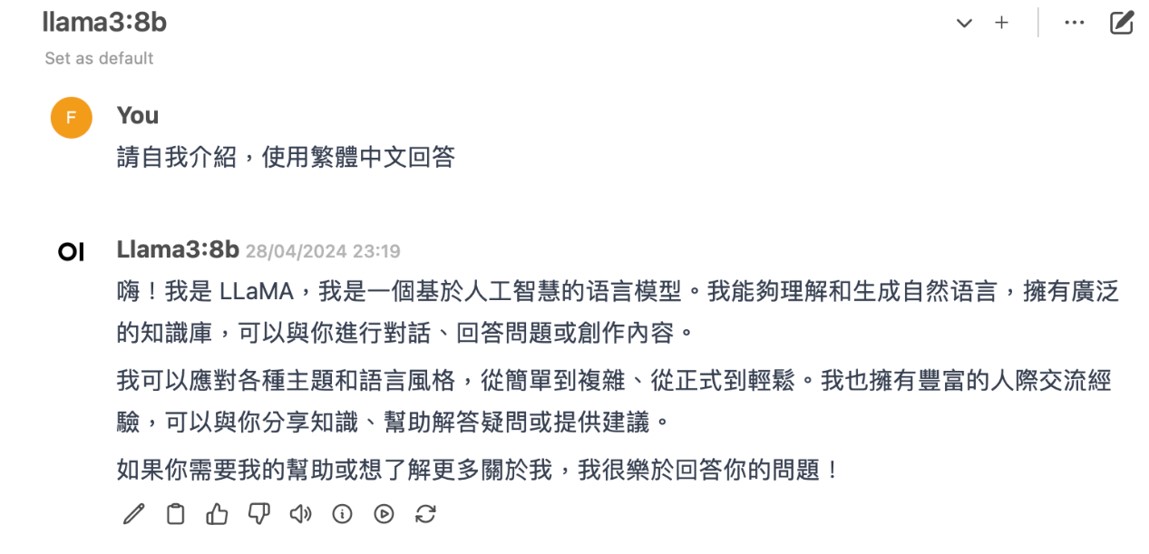

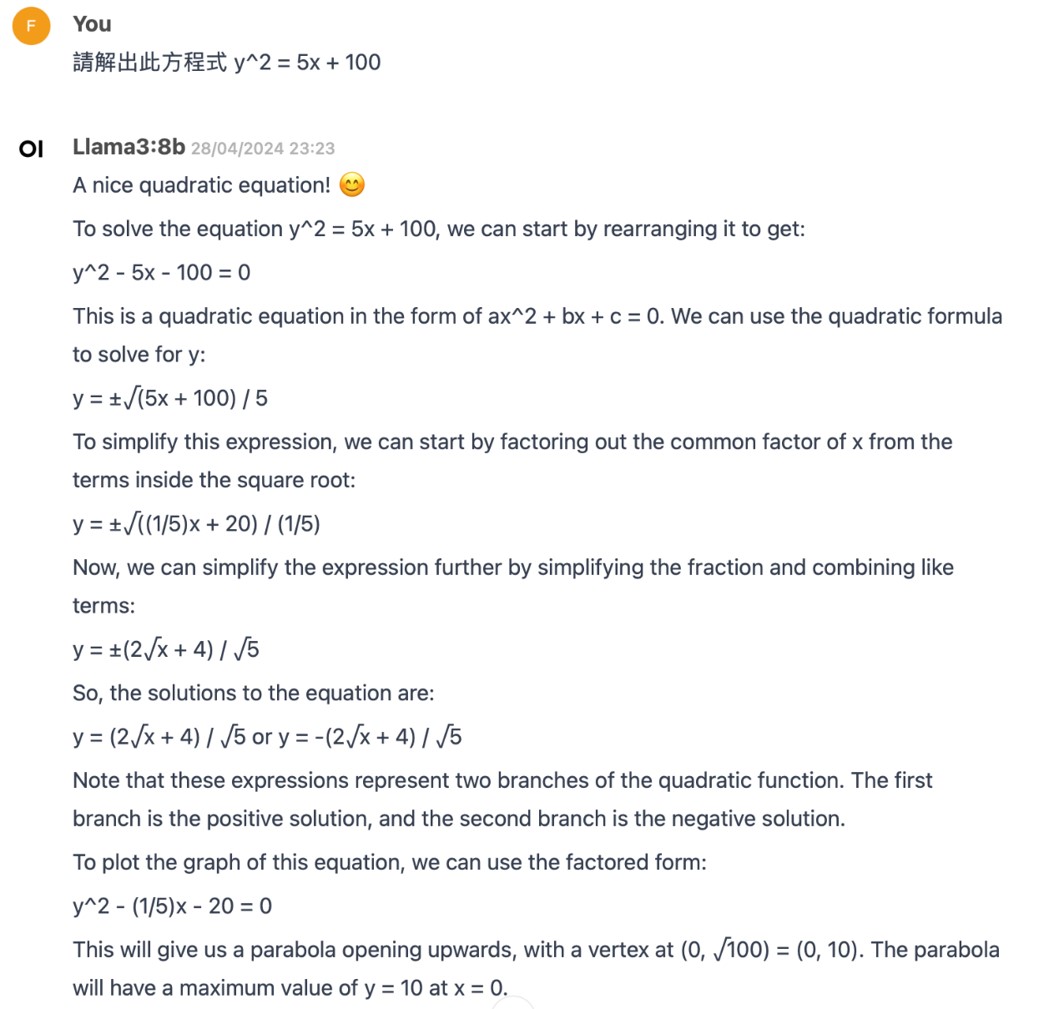

進入Open WebUI後,首先選擇此次所要使用的本地端模型

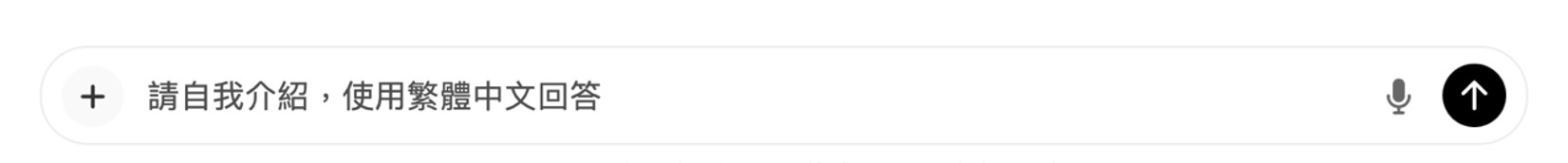

接著到畫面下方的輸入框輸入您的問題即可

之後Llama 3:8b將回答您的問題

至此您已經在本地端部署目前最新、最強大的開源大語言模型Llama 3,後續您可以自由地探索Llama 3的各種功能。

🔎學習推薦

0 意見:

張貼留言